CES2026 その2 液浸データセンターの登場は近そう

CES2026はAI、人型ロボットだらけだった訳ですが、その裏側でデータセンターの常識が大きく変わりそうな気配です。

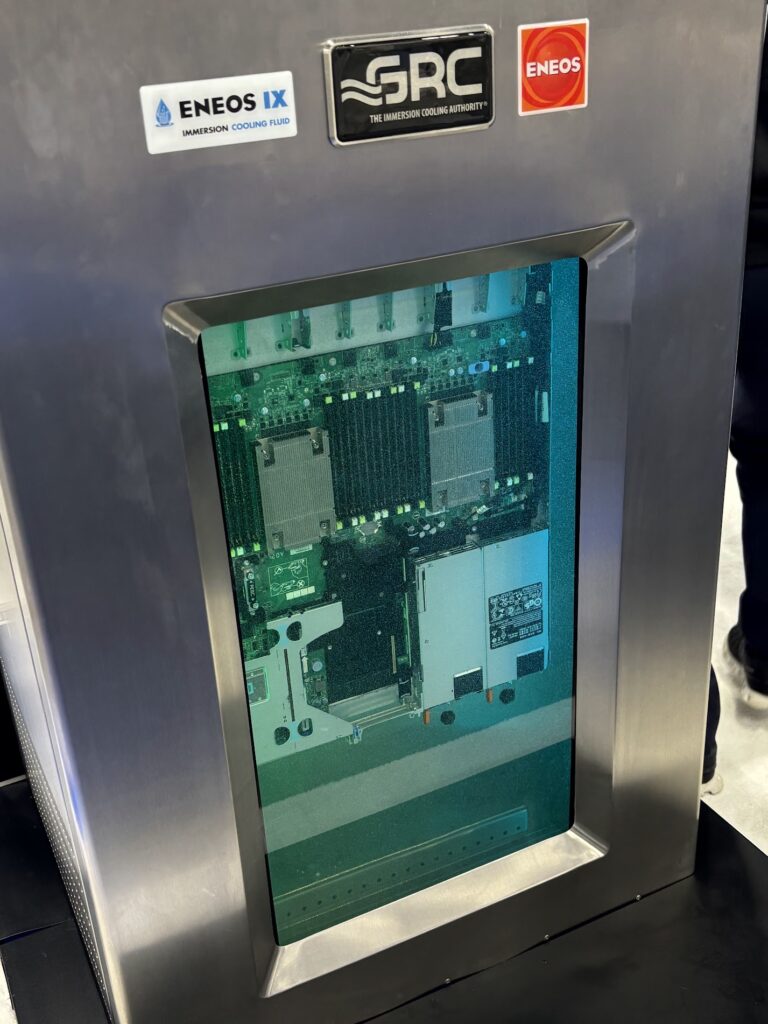

具体的には、これまでの空冷から、液冷、それも液浸、ボードを冷却液に突っ込めという、一見乱暴な話です。

AIといえばNVidia、彼らが新しいチップを次々出しているわけですが、ともかく総電力量がべらぼうに増えています。ハイパースケーラーの登場前は、ラック当たり6kVAだったのが、ハイパースケーラーが出てきて、普通にラック当たり10kVAを超えて15kVA相当になっています。そして、AI対応ラックは、なんと、60kVAを超えて今年は100kVA超え、それも150kVAは当然といった感じです。

そもそも、電力の調達も大変な訳ですが、それ以上にやっかいなのが冷却です。今でも、データセンターのコストの30%近くが冷却周りといわれているのですが、100kVAラックとなると、そもそも空冷は、どうあがいてもダメ。水冷も、金属プレートを液体で冷やすタイプの液冷で、ギリギリと思われます。それも、後5年以内に熱対応困難となりそうな気配です。

ということで、残る冷却方法は、液浸、つまり冷却液にボードをドップリとつけ込む形になります。このスタイルは、冷却に限定すれば、ラック当たり100kVAどころか、300~500kVA(2030年頃の予測値)も、一応対応可能です。

ただし、実運用の観点では難問山盛りです。

少し考えてみても、ラックは縦置きではなく、横置きになります。冷却液分の重量もすさまじく、これまでの1~1.2tではダメで、1.5tスタートです。しかもラックを上に重ねるのは相当厳しい。北米ではスラブの上に直置きとも聞きます。

また、運用もたいへん、ボードを持ち上げるクレーン装備が実際商用化されています。手でもちあげれば?と思いますが、冷却液の温度はモノによっては50度を超えてきます。手で触るのは厳しい。当然、震災対応のオペレーションなど、誰も考えていません。先行する北米は、そもそも、データセンターの耐震には無頓着でベンダーもあまり気にしていません(その代わりにテロには異常に警戒感が強いのでオペルームだけでなく、防弾ガラスとかデフォになっています)

直感的に考えても、オフィスの施設というよりは、メッキ工場の設備に近い訳で、設備管理の負担はそうとう大きくなるでしょう。

コンテナ型データセンターシフトの始まりか?

このような状況下で、日本も含めてコンテナ型データセンターへの注目が高まっています。液浸対応のノウハウ蓄積、段階的な投資等を考えると、これまでのような大規模施設をドカンと一発、建てようというのはむしろリスク大となる訳です。

これが、データセンターのこれまでの常識と相反します。これまで、データセンターは大規模、少なくとも3000㎡を最低規模とすべき、というのがセオリーでした。その心は、冷却の効率を高めるには、設備を大きくすることで、立体のデータセンターの表面積は相対的に抑えられ、冷却効率が高まる。例えるとデータセンターは恐竜のようなもので、大きい方が熱効率がよくなるわけです。

従来セオリーでいうと、コンテナ型データセンターは非効率でした。小さなユニットに、いちいち冷却機能が付いているわけで、設備拡張はコンテナ数を増やす訳で、冷却の効率は基本的には上がりません。乱暴な言い方ですが、従来の大規模センターは冷却が固定費として抑制傾向になりますが、コンテナ型データセンターは冷却が変動費そのものであり、顧客をいくら獲得しても、冷却費用の増加抑制が実現しません。つまり、儲けが激増していかない訳です。

発想の転換なのか?

こう書くと、コンテナダメじゃん、となるわけですが、AI対応の高電力ラックは、そもそも多量のGPUを収納できないという点に注意が必要です。一番上のNVidia対応ラックを見ても、ラックのなかにあるGPUサーバーの数は、予想よりも少ないです。理由は電力供給ではなく、冷却性能の制約です。つまり、大規模データセンターを作っても、液浸でなけれせば、その中をGPUで埋めつくすことは、現時点では難しい。むしろ、液浸ラックは、その他製品に比較して、電力さえあれば3~4倍のGPUを収納するだけの冷却性能が実現できます。原発のとなりに大規模な施設を建てるとしても、やはり、冷却の観点から、GPU大量収納が可能な、高密度液浸ラック単位での管理から、段階的に増加させていくことが現実的なアプローチとなりそうです。

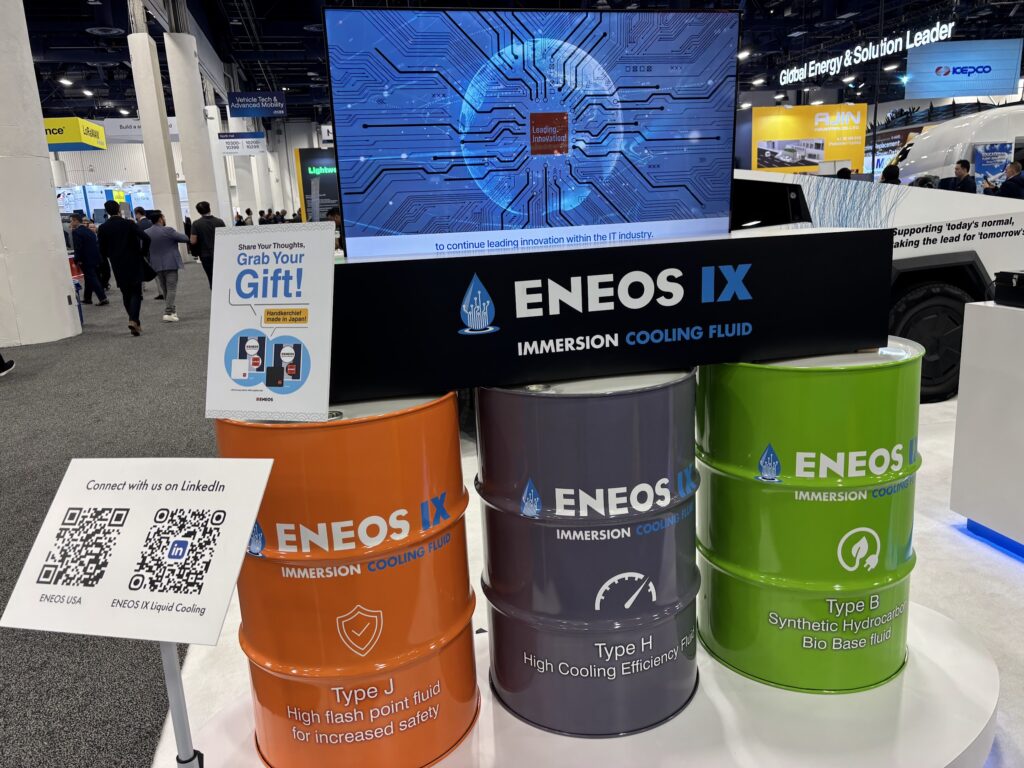

ちなみにENEOS製品をみると、冷却性能だけでなく、廃液の環境対応まで含めたラインアップのようで、韓国で見たCASTROLに負けない品揃えのようで、要注目です。