ローカルLLMの立ち位置。流れは来ているか?

ローカルLLM関連のネットイベントで講演してきました。NVidiaさん、日系ソリューションプロバイダーさんなどが参加されて、オンプレ視点のアプローチ、対応アプリなど活発な紹介で勉強になりました。

生成AIの普及はいわずもがなで、日本が諸外国に比較して導入が遅れがちなのも確かなのですが、さすがに日本においてもレイトアダプターに手が届きそうなところまでは来ており、生成AIの利用もChatGPT、Co-Pilot一本槍とは言えなくなってきました。市場の注目は昨年の初めごろから、それなりに、企業のみなさんも意識させていたようですが、業種や企業規模の点で、少し傾向が変わっているように感じます。

【元気、前向きなのは、設備を持つ企業】

具体的には、いわゆる生成AIの先進ユーザー、いわゆる企画、マーケティング、議事録、翻訳、更にはプログラミングといったホワイトカラー領域ではなく、エネルギー、交通、製造、それも機械などの設備を持っている、もしくは設備を運用している業種、企業の動きが相対的に活発だと思われます。

私自身も、いくつかのお客様とお話をするなかで、研究所の所長や工場の生産技術部門の方たちが、2024年頃から部門の予算で、50万円ぐらいのGPU+PCを、部門裁量で購入、運用する例を多く見かけるようになりました。いわく「手の内化しておきたい」「本社に話すとセキュリティが問題となり、ローカルで閉じた運用とせざるを得ない」などです。SaaSモデルに比較すると、性能は低下すると分かっていても、実はプログラミングや制御なら、かなりのことは出来る。しかも、時間がたつにしたがって、ローカルモデルも性能が向上し、これまでSaaSモデルでしか対応できなかった領域も、徐々に対応可能となる、という読みがあるようです。

また、うがった見方かもしれませんが、設備を保有、運用している組織からすると、生成AIを動かすサーバーも、そこまで身構えるようなものではない、「電源は余力あるし、スペースも大丈夫、若いやつに勉強させればモチベーションも上がる」「むしろ、意欲ある若手を活性化させるツールとしては安いと思う」といった前向きな姿勢も出ています。

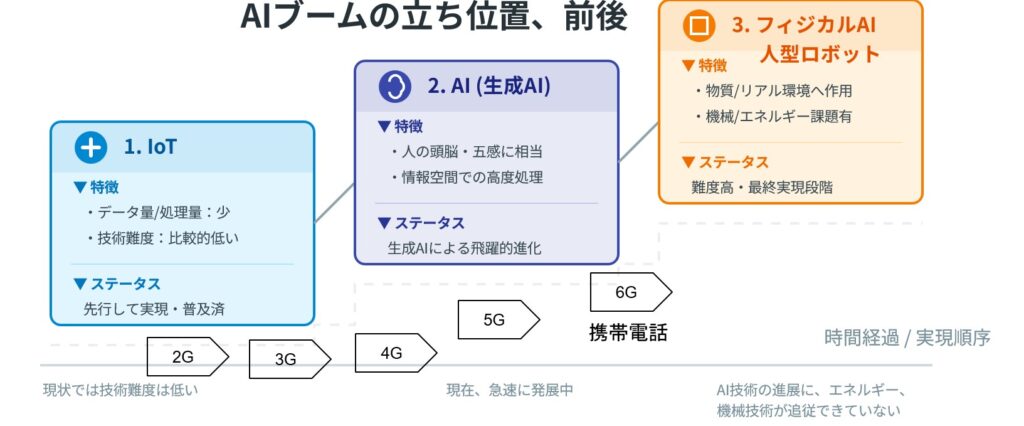

【物理AI、人型AIへのつなぎでもあるのか?】

そして、もう一つあるのが、昨今の物理AI、人型AIへの流れだと思われます。オフィスや文筆、イメージといった生成AIの適用に加えて、マルチモーダルを前提とした物理領域へのアプローチは当然の流れだと思います。そして、物理世界のAIは、多くの場合、ローカル運用を基準とし、グローバルなネットワーク接続は、バージョンアップや検査等に、より限定されていく。昔から、言われ続けて、パッとしなかったエッジコンピューティングに近づいていくように思われます。

正直な話、いまさらクラウドにあずけた資産をレパトリエーションする流れが大きくなるとは思えません。しかし、物理AI、人型AIについては、ローカルにより多くのAI機能、資産が配置されることになる・・・。ローカルLLMは、その前兆なのでは?と感じられるのです。